Į³Ų┌░ó└’░═░═Ą─═¼īW(xu©”)ĘųŽĒ┴╦░ó└’į┌“«ÉĄžļp╗Ņ”Ż©╬ó▓®ĘQ“ČÓÖCĘ┐▓┐╩”Ż¼×ķ▒Ńė┌└ĒĮŌ▒Š╬─Įy(t©»ng)ĘQ“«ÉĄžČÓ╗Ņ”Ż®Ą─ę╗ą®Įø(j©®ng)“ׯ© http://www.infoq.com/cn/articles/interview-alibaba-bixuan Ż®Ż¼ė╔ė┌╬ęį°┤·▒ĒŲĮ┼_į┌2012─Ļų„ī¦(d©Żo)╬ó▓®Ą─ÅVų▌ÖCĘ┐▓┐╩ĒŚ─┐ęį╝░▒▒Š®ļpÖCĘ┐▓┐╩ĒŚ─┐Ż¼ę▓ĘųŽĒę╗Ž┬╬ó▓®į┌ČÓÖCĘ┐▓┐╩ĘĮ├µĄ─ę╗ą®ą─Ą├║═▓╚▀^Ą─┐ėĪŻ

«ÉĄžČÓ╗ŅĄ─║├╠Ä░ó└’═¼īW(xu©”)ęčĮø(j©®ng)│õĘųĻU╩÷Ż¼╬ó▓®Ą─│§╩╝│÷░l(f©Ī)³c░³└©«ÉĄž×─(z©Īi)éõĪó╠ß╔²─ŽĘĮļŖą┼ė├æ¶įLå¢╦┘Č╚Īó╠ß╔²║Ż═Ōė├æ¶įLå¢╦┘Č╚ĪóĮĄĄ═▓┐╩│╔▒ŠŻ©▒▒Š®ÖCĘ┐ÖC╝▄┘M╠½┘F┴╦Ż®Ą╚ĪŻ═©▀^īŹ█`░l(f©Ī)¼F(xi©żn)ā×(y©Łu)ä▌░³└©«ÉĄž╚▌×─(z©Īi)ĪóäėæB(t©żi)╝ė╦┘Īó┴„┴┐Š∙║ŌĪóį┌ŠĆē║£yĄ╚Ż¼Č°╠¶æ(zh©żn)░³└©į÷╝ėčą░l(f©Ī)Å═(f©┤)ļsČ╚Īó┤µā”│╔▒Šį÷╝ėĄ╚ĪŻ

╬ó▓®═Ō▓┐Üv│╠

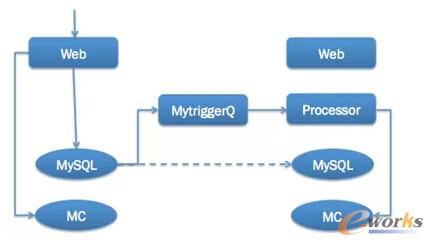

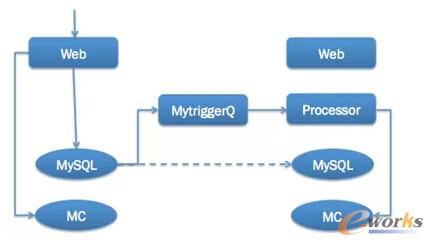

Ž╚šfšf╬ó▓®═Ō▓┐Ą─Üv│╠Ż¼š¹éĆ▀^│╠┐╔ų^╩Ūę╗▓©ČÓš█ĪŻ╬ó▓®Ą─ų„ę¬ÖCĘ┐Č╝╝»ųąį┌▒▒Š®Ż¼ų╗ėą║▄ąĪę╗▓┐ĘųśI(y©©)äš(w©┤)į┌ÅVų▌▓┐╩Ż¼2010─Ļ10į┬ę“╬ó▓®Ė▀╦┘░l(f©Ī)š╣£╩éõöU┤¾ÅVų▌ÖCĘ┐Ę■äš(w©┤)Ų„ęÄ(gu©®)─ŻŻ¼▓óī”╬ó▓®ū÷«ÉĄžļp╗Ņ▓┐╩ĪŻĄ┌ę╗░µ┐ńÖCĘ┐Ž¹Žó═¼▓ĮĘĮ░Ė▓╔╚ĪĄ─╩Ū╗∙ė┌ūį蹥─MytriggerQŻ©ĮĶų·MySQLÅ─ÄņĄ─ė|░l(f©Ī)Ų„īóINSERTĪóUPDATEĪóDELETEĄ╚╩┬╝■▐D(zhu©Żn)×ķŽ¹ŽóŻ®Ą─ĘĮ░ĖŻ¼▀@éĆĘĮ░ĖĄ─║├╠Ä╩Ū┐ńÖCĘ┐Ą─Ž¹Žó═¼▓Į═©▀^MySQLĄ─ų„Å─═Ļ│╔Ą─Ż¼ĘĮ░ĖĄ─│╔╩ņČ╚Ė▀ĪŻČ°╚▒³cät╩ŪŻ¼╬ó▓®═¼ę╗éĆśI(y©©)äš(w©┤)Ģ■ėą║├ÄūÅł▒ĒŻ¼Č°├┐Åł▒ĒĄ─ą┼Žóėų▓╗╚½Ż¼▀@śė├┐░l(f©Ī)ę╗Śl╬ó▓®Ģ■ėąČÓŚlŽ¹ŽóŽ╚║¾ĄĮ▀_Ż¼▀@śėī¦(d©Żo)ų┬ėą▌^ČÓĢrą“å¢Ņ}Ż¼ŠÅ┤µ╚▌ęū╗©ĪŻĄ┌ę╗╠ūĘĮ░Ė╬┤─▄│╔╣”Ż¼Ą½ę▓ūī╬ęéāšJūR┴╦┐ńÖCĘ┐Ž¹Žó═¼▓ĮĄ─║╦ą─å¢Ņ}Ż¼▓ó┤┘╩╣╬ęéā?n©©i)½├µŽ┬ŠĆMytriggerQĄ─Ž¹Žó═¼▓ĮĘĮ░ĖŻ¼Č°Ė─ė├╗∙ė┌śI(y©©)äš(w©┤)ī掹ŽóĄĮMCQŻ©MemcacheQŻ¼ą┬└╦ūį蹥─ę╗╠ūŽ¹ŽóĻĀ┴ąŻ¼ŅÉMCģf(xi©”)ūhŻ¼ģóęŖ http://memcachedb.org/memcacheq/ Ż®Ą─ĮŌøQĘĮ░ĖĪŻ

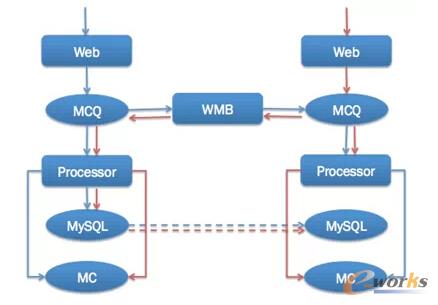

2011─ĻĄūį┌╬ó▓®ŲĮ┼_╗»═Ļ│╔║¾Ż¼ķ_╩╝åóė├╗∙ė┌MCQŻ©╬ó▓®ūį蹥─Ž¹ŽóĻĀ┴ąŻ®Ą─┐ńÖCĘ┐Ž¹Žó═¼▓ĮĘĮ░ĖŻ¼▓óķ_░l(f©Ī)│÷┐ńÖCĘ┐Ž¹Žó═¼▓ĮĮM╝■WMBŻ©Weibo Message BrokerŻ®ĪŻĮø(j©®ng)▀^┼c╬ó▓®PCČ╦Ą╚▓┐ķT═¼īW(xu©”)Ą─╣▓═¼┼¼┴”Ż¼ĮKė┌į┌2012─Ļ5į┬═Ļ│╔Weibo.comį┌ÅVų▌ÖCĘ┐Ą─╔ŽŠĆŻ¼īŹ¼F(xi©żn)┴╦“«ÉĄžļp╗Ņ”ĪŻ

ė╔ė┌ÅVų▌ÖCĘ┐┐é¾wĄ─ÖCŲ„ęÄ(gu©®)─Ż▌^ąĪŻ¼×ķ┴╦╠ß╔²╬ó▓®║╦ą─ŽĄĮy(t©»ng)╚▌×─(z©Īi)─▄┴”Ż¼2013─Ļ─Ļųą╬ęéāėųīó▒▒Š®Ą─ÖCĘ┐▀Mąą▓ĘųŻ¼ų┴┤╦╬ó▓®ŲĮ┼_īŹ¼F(xi©żn)┴╦«ÉĄž╚²╣Ø(ji©”)³cĄ─▓┐╩─Ż╩ĮĪŻę└═ąė┌┤╦─Ż╩ĮŻ¼╬ó▓®Š▀éõ┴╦į┌ŠĆ╚▌┴┐įu╣└ĪóĘų╝ē╔ŽŠĆĪó┐ņ╦┘┴„┴┐Š∙║ŌĄ╚─▄┴”Ż¼æ¬(y©®ng)ī”śOČ╦ĘÕųĄ─▄┴”║═æ¬(y©®ng)ī”╣╩šŽ─▄┴”┤¾┤¾╠ß╔²Ż¼ų«║¾Üv┤╬į¬Ą®Īó┤║═ĒĘÕųĄŠ∙Ēś└¹æ¬(y©®ng)ī”Ż¼╚š│Ż╔ŽŠĆī¦(d©Żo)ų┬Ą─╣╩šŽę▓┤¾┤¾£p╔┘ĪŻ╔ŽŠĆ║¾Ż¼Ė∙ō■(j©┤)╬ó▓®▀\ĀIŪķør╝░│╔▒ŠĄ─ąĶ꬯¼ę▓į°öĄ(sh©┤)┤╬š{(di©żo)š¹Ė„éĆÖCĘ┐Ą─Ę■äš(w©┤)Ų„ęÄ(gu©®)─ŻŻ¼Ą½╩Ūš¹╠ū╝╝ąg(sh©┤)╔ŽęčĮø(j©®ng)╗∙▒Š│╔╩ņĪŻ

«ÉĄžČÓ╗Ņ├µ┼RĄ─╠¶æ(zh©żn)

Ė∙ō■(j©┤)╬ó▓®Ą─īŹ█`Ż¼ę╗░Ńū÷«ÉĄžČÓ╗ŅČ╝Ģ■ė÷ĄĮ╚ńŽ┬Ą─å¢Ņ}Ż║

ÖCĘ┐ų«ķgĄ─čėĢrŻ║╬ó▓®▒▒Š®Ą─ā╔éĆ║╦ą─ÖCĘ┐ķgčėĢrį┌1msū¾ėęŻ¼Ą½▒▒Š®ÖCĘ┐ĄĮÅVų▌ÖCĘ┐ätėąĮ³40msĄ─čėĢrĪŻī”▒╚ę╗Ž┬Ż¼╬ó▓®║╦ą─FeedĮė┐┌Ą─┐éŲĮŠ∙║─Ģrę▓Š═į┌120msū¾ėęĪŻ╬ó▓®FeedĢ■ę└┘ćÄū╩«éĆĘ■äš(w©┤)╔Ž░┘éĆ┘Yį┤Ż¼╚ń╣¹Č╝┐ńÖCĘ┐šłŪ¾Ż¼ąį─▄īóĢ■æK▓╗╚╠Č├Ż╗

īŻŠĆå¢Ņ}Ż║×ķ┴╦ū÷ÅVų▌ÖCĘ┐═Ō▓┐Ż¼╬ó▓®ūŌ┴╦ā╔Śl▒▒Š®ĄĮÅVų▌Ą─īŻŠĆŻ¼│╔▒ŠŠ▐┤¾ĪŻ═¼Ģrå╬ŚlīŻŠĆĄ─ĘĆ(w©¦n)Č©ąįę▓║▄ļy▒ŻšŽŻ¼╗∙▒Š╔Ž├┐éĆį┬Č╝Ģ■ėą╗“┤¾╗“ąĪĄ─å¢Ņ}Ż╗

öĄ(sh©┤)ō■(j©┤)═¼▓Įå¢Ņ}Ż║MySQL╚ń║╬ū÷öĄ(sh©┤)ō■(j©┤)═¼▓ĮŻ┐HBase╚ń║╬ū÷öĄ(sh©┤)ō■(j©┤)═¼▓ĮŻ┐▀ĆėąĖ„ĘNūį蹥─ĮM╝■Ż¼▀@ą®Įy(t©»ng)Įy(t©»ng)ę¬ū÷ČÓÖCĘ┐öĄ(sh©┤)ō■(j©┤)═¼▓ĮĪŻÄū╩«║┴├ļĄ─čėĢrŻ¼╝ė╔Ž┬Ę═Š▀b▀hī¦(d©Żo)ų┬Ą─▌^╚§ŠW(w©Żng)Įj(lu©░)┘|(zh©¼)┴┐Ż©╬ęéāĄ─īŻŠĆ├┐éĆį┬Č╝Ģ■ėą╗“┤¾╗“ąĪĄ─å¢Ņ}Ż®Ż¼öĄ(sh©┤)ō■(j©┤)═¼▓Į╩ŪĘŪ│Ż┤¾Ą─╠¶æ(zh©żn)Ż╗

ę└┘ćĘ■äš(w©┤)▓┐╩å¢Ņ}Ż║╚ń═¼░ó└’─┐Ū░ų╗ū÷┴╦Į╗ęūå╬į¬Ą─“«ÉĄžļp╗Ņ”Ż¼╬ó▓®▓┐╩Ģrę▓├µ┼R║╦ą─Ę■äš(w©┤)▀^ČÓę└┘ćąĪĘ■äš(w©┤)Ą─å¢Ņ}ĪŻīóąĪĘ■äš(w©┤)╚½▓┐▓┐╩Ė─įņ│╔▒ŠĪóŠSūo│╔▒Š▀^┤¾Ż¼▓╗▓┐╩ätĢ■ė÷ĄĮų«Ū░╠ߥĮĄ─ÖCĘ┐ų«ķgčėĢrī¦(d©Żo)ų┬š¹¾wąį─▄¤oĘ©Įė╩▄Ą─å¢Ņ}Ż╗

┼õ╠ū¾wŽĄå¢Ņ}Ż║ų╗╩ŪĘ■äš(w©┤)▓┐╩ø]ėą┴„┴┐ę²╚ļŠ═▓╗─▄ĘQ×ķ“ļp╗Ņ”Ż¼Č°ę¬ę²╚ļ┴„┴┐Š═ę¬Ū¾┼õ╠ūĄ─Ę■äš(w©┤)║═┴„│╠Č╝─▄ų¦│ų«ÉĄž▓┐╩Ż¼░³└©ŅA(y©┤)ė[Īó░l(f©Ī)▓╝Īó£yįćĪó▒O(ji©Īn)┐žĪóĮĄ╝ēĄ╚Č╝ę¬▀MąąŽÓæ¬(y©®ng)Ė─įņŻ╗

╬ó▓®«ÉĄžČÓ╗ŅĮŌøQĘĮ░Ė

ė╔ė┌Äū╩«║┴├ļĄ─čėĢrŻ¼┐ńÖCĘ┐Ę■äš(w©┤)š{(di©żo)ė├ąį─▄║▄▓ŅŻ¼«ÉĄžČÓ╗Ņ▓┐╩Ą─ų„¾wĘ■äš(w©┤)▒žĒÜę¬ū÷öĄ(sh©┤)ō■(j©┤)Ą─╚▀ėÓ┤µā”Ż¼▓ó▌oęįŠÅ┤µĄ╚śŗ(g©░u)│╔ę╗╠ū¬Ü┴óČ°ŽÓī”═Ļš¹Ą─Ę■äš(w©┤)ĪŻöĄ(sh©┤)ō■(j©┤)═¼▓Įėą║▄ČÓīė├µŻ¼░³└©Ž¹Žóīė├µĪóŠÅ┤µīė├µĪóöĄ(sh©┤)ō■(j©┤)Äņīė├µŻ¼├┐ę╗éĆīė├µČ╝┐╔ęįū÷öĄ(sh©┤)ō■(j©┤)═¼▓ĮĪŻė╔ė┌╗∙ė┌MytriggerQĄ─ĘĮ░ĖĄ─╩¦öĪŻ¼╬ó▓®║¾üĒ▓╔╚ĪĄ─╩Ū╗∙ė┌MCQĄ─WMBŽ¹Žó═¼▓ĮĘĮ░ĖŻ¼▓ó═©▀^Ž¹Žóī”ŠÅ┤µĖ³ą┬Ż¼╝ė╔Ž╬ó▓®ŠÅ┤µĖ▀┐╔ė├╝▄śŗ(g©░u)Ż¼┐╔ęįū÷ĄĮ╝┤▒ŃöĄ(sh©┤)ō■(j©┤)Äņ═¼▓Įėąå¢Ņ}Å─ė├涾w“×┐┤Ę■äš(w©┤)▀Ć╩Ūš²│ŻĄ─ĪŻ

▀@╠ūĘĮ░ĖųąŻ¼├┐éĆÖCĘ┐Ą─ŠÅ┤µ╩Ū═Ļ╚½¬Ü┴óĄ─Ż¼ė╔├┐éĆÖCĘ┐Ą─ProcessorŻ©īŻķTžōž¤Ž¹Žó╠Ä└ĒĄ─│╠ą“Ż¼ŅÉStormŻ®Ė∙ō■(j©┤)╩šĄĮĄ─Ž¹Žó▀MąąŠÅ┤µĖ³ą┬ĪŻė╔ė┌Ž¹Žó▓╗Ģ■ųžÅ═(f©┤)Ęų░l(f©Ī)Ż¼Č°Ūęą┼Žó═ĻéõŻ¼╦∙ęįMytriggerQĘĮ░Ė┤µį┌Ą─ŠÅ┤µĖ³ą┬┼KöĄ(sh©┤)ō■(j©┤)å¢Ņ}Š═ĮŌøQ┴╦ĪŻČ°«öŠÅ┤µ▓╗┤µį┌ĢrŻ¼Ģ■┤®═ĖĄĮMySQLÅ─ÄņŻ¼╚╗║¾▀Mąą╗žĘNĪŻ┐╔─▄│÷¼F(xi©żn)Ą─å¢Ņ}╩ŪŻ¼ŠÅ┤µ┤®═ĖŻ¼Ą½╩ŪMySQLÅ─Äņ╚ń╣¹┤╦Ģr│÷¼F(xi©żn)čė▀tŻ¼▀@śėŠ═Ģ■░č┼KöĄ(sh©┤)ō■(j©┤)ĘNĄĮŠÅ┤µųąĪŻ╬ęéāĄ─ĮŌøQĘĮ░Ė╩Ūū÷ę╗éĆčėĢr10ĘųńŖĄ─Ž¹ŽóĻĀ┴ąŻ¼╚╗║¾ė╔ę╗éĆ╠Ä└Ē│╠ą“üĒĖ∙ō■(j©┤)▀@éĆŽ¹Žóū÷öĄ(sh©┤)ō■(j©┤)Ą─ųžą┬▌d╚ļĪŻę╗░ŃÅ─ÄņčėĢrĢrķg▓╗│¼▀^10ĘųńŖŻ¼Č°10ĘųńŖā╚(n©©i)Ą─┼KöĄ(sh©┤)ō■(j©┤)į┌╬ó▓®Ą─śI(y©©)äš(w©┤)ł÷Š░Ž┬ę▓╩Ū┐╔ęįĮė╩▄Ą─ĪŻ

╬ó▓®Ą─«ÉĄžČÓ╗ŅĘĮ░Ė╚ńŽ┬łDŻ©╚²éĆ╣Ø(ji©”)³cŅÉ╦ŲŻ¼Ž¹Žó═¼▓ĮČ╝╩Ū═©▀^WMBŻ®Ż║

Ė·░ó└’═¼īW(xu©”)ė÷ĄĮĄ─å¢Ņ}ŅÉ╦ŲŻ¼╬ęéāę▓ė÷ĄĮöĄ(sh©┤)ō■(j©┤)Äņ═¼▓ĮĄ─å¢Ņ}ĪŻė╔ė┌╬ó▓®ī”öĄ(sh©┤)ō■(j©┤)Äņ▓╗╩ŪÅŖę└┘ćŻ¼╝ė╔ŽöĄ(sh©┤)ō■(j©┤)ÄņļpīæĄ─ŠSūo│╔▒Š▀^┤¾Ż¼╬ęéā▀xō±Ą─ĘĮ░Ė╩ŪöĄ(sh©┤)ō■(j©┤)Äņ═©▀^ų„Å─═¼▓ĮĄ─ĘĮ╩Į▀MąąĪŻ▀@╠ūĘĮ░Ė┐╔─▄Ą─╚▒³c╩Ū╚ń╣¹ų„Å─═¼▓Į┬²Ż¼▓óŪęŠÅ┤µ┤®═ĖŻ¼▀@Ģr┐╔─▄Ģ■│÷¼F(xi©żn)┼KöĄ(sh©┤)ō■(j©┤)ĪŻ▀@ĘN═¼▓ĮĘĮ╩Įęč▀\ąą┴╦╚²─ĻŻ¼š¹¾w╔ŽĘŪ│ŻĘĆ(w©¦n)Č©Ż¼ø]ėą░l(f©Ī)╔·ę“×ķöĄ(sh©┤)ō■(j©┤)═¼▓ĮČ°ī¦(d©Żo)ų┬Ą─Ę■äš(w©┤)╣╩šŽĪŻÅ─2013─Ļķ_╩╝Ż¼╬ó▓®åóė├HBaseū÷į┌ŠĆśI(y©©)äš(w©┤)Ą─┤µā”ĮŌøQĘĮ░ĖŻ¼ė╔ė┌HBase▒Š╔Ē▓╗ų¦│ųČÓÖCĘ┐▓┐╩Ż¼╝ė╔ŽįńŲ┌HBaseĄ─śI(y©©)äš(w©┤)▒╚▌^ąĪŻ¼Ūęėąå╬¬ÜĮė┐┌┐╔ęį╗žš{(di©żo)▒▒Š®ÖCĘ┐Ż¼╦∙ęįø]ėąū÷«ÉĄž▓┐╩ĪŻĄĮĮ±─Ļė╔ė┌HBaseų¦ō╬Ą─ī”Ž¾ÄņĘ■äš(w©┤)ęčĮø(j©®ng)│╔×ķ╬ó▓®ĘŪ│Ż║╦ą─Ą─╗∙ĄA(ch©│)Ę■äš(w©┤)Ż¼╬ęéāę▓į┌ęÄ(gu©®)äØHBaseĄ─«ÉĄž▓┐╩ĘĮ░ĖŻ¼ų„ꬥ─╦╝┬ĘĖ·MySQLĄ─ĘĮ░ĖŅÉ╦ŲŻ¼═¼▓Įę▓į┌┐╝æ]╗∙ė┌MCQ═¼▓ĮĄ─ļpÖCĘ┐HBase¬Ü┴ó▓┐╩ĘĮ░ĖĪŻ

░ó└’▀xō±┴╦å╬į¬╗»Ą─ĮŌøQĘĮ░ĖŻ¼▀@╠ūĘĮ░ĖĄ─ā×(y©Łu)ä▌╩Ūīóė├æ¶Ęųģ^(q©▒)Ż¼╚╗║¾╦∙ėą▀@éĆė├涎ÓĻP(gu©Īn)Ą─öĄ(sh©┤)ō■(j©┤)Č╝į┌ę╗éĆå╬į¬└’ĪŻ═©▀^▀@╠ūĘĮ░ĖŻ¼┐╔ęį▌^║├Ą─┐žųŲ│╔▒ŠĪŻĄ½╚▒³c╩Ū│²┴╦ų„ŠSČ╚Ż©░ó└’╩Ū┘I╝ęŠSČ╚Ż®Ż¼Ųõ╦¹╦∙ėąĄ─öĄ(sh©┤)ō■(j©┤)▀Ć╩Ūę¬ū÷┐ńÖCĘ┐═¼▓ĮŻ¼š¹¾wĄ─Å═(f©┤)ļsČ╚╗∙▒Šø]ĮĄĄ═ĪŻ┴Ē═ŌŠ═╩ŪöĄ(sh©┤)ō■(j©┤)Ęųļx║¾ė╔ė┌▓│╔┴╦ų┴╔┘ā╔Ę▌öĄ(sh©┤)ō■(j©┤)Ż¼öĄ(sh©┤)ō■(j©┤)▓ķįāĪóöUš╣Īóå¢Ņ}╠Ä└ĒĄ╚│╔▒ŠŠ∙Ģ■į÷╝ė▌^ČÓĪŻ┐éĄ─üĒųvŻ¼éĆ╚╦šJ×ķ▀@╠ūĘĮ░ĖĖ³▀mė├ė┌What

SAPpĪóInstagramĄ╚ć°═ŌśI(y©©)äš(w©┤)ŽÓī”║åå╬Ą─æ¬(y©®ng)ė├Ż¼Č°▓╗▀mė├ė┌ć°ā╚(n©©i)╣”─▄Ę▒ļsę└┘ć▒ŖČÓĄ─æ¬(y©®ng)ė├ĪŻ

öĄ(sh©┤)ō■(j©┤)═¼▓Įå¢Ņ}ĮŌøQų«║¾Ż¼ŠoĮėų°Š═ę¬ĮŌøQę└┘ćĘ■äš(w©┤)▓┐╩Ą─å¢Ņ}ĪŻė╔ė┌╬ó▓®ŲĮ┼_ī”═Ō╠ß╣®Ą─Č╝╩ŪRestful’LĖ±Ą─APIĮė┐┌Ż¼╦∙ęį¬Ü┴óśI(y©©)äš(w©┤)Ą─Įė┐┌┐╔ęįų▒Įė═©▀^īŻŠĆę²┴„╗ž▒▒Š®ÖCĘ┐ĪŻĄ½╩Ūī”ė┌╬ó▓®FeedĮė┐┌Ą─ę└┘ćĘ■äš(w©┤)Ż¼ų▒Įėę²┴„╗ž▒▒Š®ÖCĘ┐Ģ■īóŲĮŠ∙╠Ä└ĒĢrķgÅ─░┘║┴├ļĄ─┴┐╝ēų▒Įė╔²ų┴Äū├ļĄ─┴┐╝ēŻ¼▀@ī”Ę■äš(w©┤)╩Ū¤oĘ©Įė╩▄Ą─ĪŻ╦∙ęįŻ¼į┌2012─Ļ╬ęéāī”╬ó▓®Feedę└┘ćĄ─ų„ę¬Ę■äš(w©┤)ę▓ū÷┴╦«ÉĄžČÓ╗Ņ▓┐╩Ż¼š¹¾wĄ─╠Ä└ĒĢrķgĮKė┌ĮĄ┴╦Ž┬üĒĪŻ«ö╚╗▀@▓╗╩ŪūŅā×(y©Łu)Ą─ĮŌøQĘĮ░ĖŻ¼Ą½į┌«öĢr╬ó▓®śI(y©©)äš(w©┤)¾wŽĄ▀ĆŽÓī”║åå╬Ą─ŪķørŽ┬║▄║├Ą─ĮŌøQ┴╦å¢Ņ}Ż¼┤_▒Ż┴╦2012─Ļ5į┬Ą─ÅVų▌ÖCĘ┐▓┐╩╚╬äš(w©┤)Ą─▀_│╔ĪŻ

Č°┼õ╠ū¾wŽĄĄ─å¢Ņ}Ż¼╝╝ąg(sh©┤)╔Ž▓╗╩Ū║▄Å═(f©┤)ļsŻ¼Ą½╩Ū▓┘ū„Ą─Ģr║“╚▒║▄╚▌ęū│÷å¢Ņ}ĪŻ▒╚╚ńŻ¼╬ó▓®äéķ_╩╝ū÷«ÉĄžČÓ╗Ņ▓┐╩ĢrŻ¼£yįć═¼īW(xu©”)ø]ėąį┌╔ŽŠĆĢrī”ÅVų▌ÖCĘ┐ū÷ŅA(y©┤)ė[£yįćŻ¼į°Įø(j©®ng)ī¦(d©Żo)ų┬▀^ę╗ą®ŠĆ╔Žå¢Ņ}ĪŻ┼õ╠ū¾wŽĄąĶę¬Ė▓╔wš¹éĆśI(y©©)äš(w©┤)čą░l(f©Ī)ų▄Ų┌Ż¼░³└©ĘĮ░ĖįO(sh©©)ėŗļAČ╬Ą─╩Ūʱę¬ū÷ČÓÖCĘ┐▓┐╩Īó▓┐╩ļAČ╬Ą─öĄ(sh©┤)ō■(j©┤)═¼▓ĮĪó░l(f©Ī)▓╝ŅA(y©┤)ė[Īó░l(f©Ī)▓╝╣żŠ▀ų¦│ųĪó▒O(ji©Īn)┐žĖ▓╔wų¦│ųĪóĮĄ╝ē╣żŠ▀ų¦│ųĪó┴„┴┐▀węŲ╣żŠ▀ų¦│ųĄ╚ĘĮĘĮ├µ├µŻ¼▓óąĶķ_░l(f©Ī)Īó£yįćĪó▀\ŠSČ╝ģó┼c▀MüĒŻ¼īóĻP(gu©Īn)µI³c╝{╚ļĄĮ┴„│╠«öųąĪŻ

ĻP(gu©Īn)ė┌×ķæ¬(y©®ng)ī”╣╩šŽČ°▀MąąöĄ(sh©┤)ō■(j©┤)╚▀ėÓå¢Ņ}Ż¼░ó└’Ą─═¼īW(xu©”)ę▓ū÷┴╦│õĘųĄ─ĻU╩÷Ż¼į┌┤╦ę▓ča│õę╗Ž┬╬ęéāĄ─ę╗ą®Įø(j©®ng)“×ĪŻ╬ó▓®║╦ą─│ž╚▌┴┐╚▀ėÓĘųā╔éĆīė├µüĒū÷Ż¼Ū░Č╦Webīė╚▀ėÓ═¼ė├æ¶ęÄ(gu©®)─Ż│╔š²▒╚Ż¼▓óŅA(y©┤)┴¶╚š│ŻĘÕųĄ50%ū¾ėęĄ─╚▀ėÓČ╚Ż¼Č°║¾Č╦ŠÅ┤µĄ╚┘Yį┤ė╔ė┌ŽÓī”│╔▒Š▌^Ą═Ż¼├┐éĆÖCĘ┐Š∙░┤ššš¹¾wā╔▒ČĄ─ęÄ(gu©®)─Ż▀Mąą╚▀ėÓĪŻ▀@śė╚ń╣¹─│ę╗éĆÖCĘ┐▓╗┐╔ė├Ż¼╩ūŽ╚╬ęéā║¾Č╦Ą─┘Yį┤╩ŪūŃē“Ą─ĪŻĮėų°╬ęéā╩ūŽ╚Ģ■ų╗īó║╦ą─Įė┐┌▀Mąą▀węŲŻ¼▀@éĆ▓┘ū„ĘųńŖ╝ē╝┤┐╔═Ļ│╔Ż¼═¼Ģrė╔ė┌╚▀ėÓ╩Ū░┤ššš¹¾wĄ─50%Ż¼╦∙ęį╝┤╩╣╦∙ėąĄ─║╦ą─Įė┐┌┴„┴┐╚½▓┐▀węŲ▀^üĒę▓─▄ų¦ō╬ūĪĪŻĮėŽ┬üĒŻ¼╬ęéāīóĢ■░čŲõ╦¹Ę■äš(w©┤)│žĄ─Ū░Č╦ÖCę▓Ė─×ķ▓┐╩║╦ą─│žŪ░Č╦ÖCŻ¼▀@śėį┌ę╗ąĪĢrā╚(n©©i)╝┤┐╔īŹ¼F(xi©żn)š¹¾w┴„┴┐Ą─│ąĮėĪŻ═¼ĢrŻ¼╚ń╣¹╣╩šŽÖCĘ┐╩Ūžōž¤öĄ(sh©┤)ō■(j©┤)┬õĄžĄ─ÖCĘ┐Ż¼DBAĢ■īóÅ─Äņ╔²×ķų„ÄņŻ¼▀\ŠSš{(di©żo)š¹ĻĀ┴ąÖCķ_ĻP(gu©Īn)┼õų├Ż¼│ąĮėöĄ(sh©┤)ō■(j©┤)┬õĄž╣”─▄ĪŻČ°į┌š¹éĆ▀^│╠ųąŻ¼ė╔ė┌╬ęéā║╦ą─ŠÅ┤µ┐╔ęį├ōļxöĄ(sh©┤)ō■(j©┤)Äņų¦ō╬ę╗éĆąĪĢrū¾ėęŻ¼╦∙ęįĘ■äš(w©┤)š¹¾wĢ■▒Ż│ųŲĮĘĆ(w©¦n)ĪŻ

«ÉĄžČÓ╗ŅūŅ║├Ą─ū╦ä▌

ęį╔ŽĮķĮB┴╦ę╗Ž┬╬ó▓®į┌«ÉĄžČÓ╗ŅĘĮ├µĄ─īŹ█`║═ą─Ą├Ż¼ę▓ī”▒╚┴╦ę╗Ž┬░ó└’Ą─ĮŌøQĘĮ░ĖĪŻŠ═Ž±ø]ėą═Ļ├└Ą─═©ė├╝▄śŗ(g©░u)ę╗śėŻ¼«ÉĄžČÓ╗ŅĄ─ūŅ╝čĘĮ░Ėę▓ę¬ę“śI(y©©)äš(w©┤)Ūķą╬Č°Č©ĪŻ╚ń╣¹śI(y©©)äš(w©┤)šłŪ¾┴┐▒╚▌^ąĪŻ¼ätĖ∙▒Šø]ėą▒žę¬ū÷«ÉĄžČÓ╗ŅŻ¼öĄ(sh©┤)ō■(j©┤)Äņ└õéõūŃē“┴╦ĪŻ▓╗╣▄──ĘNĘĮ░ĖŻ¼«ÉĄžČÓ╗ŅĄ─┘Yį┤│╔▒ŠĪóķ_░l(f©Ī)│╔▒ŠŽÓ▒╚┼cå╬ÖCĘ┐▓┐╩─Ż╩ĮČ╝Ģ■┤¾┤¾į÷╝ėĪŻ

ęįŽ┬╩ŪĘĮ░Ė▀xą═ĢrąĶę¬┐╝æ]Ą─ę╗ą®ŠSČ╚Ż║

─▄ʱš¹śI(y©©)äš(w©┤)▀węŲŻ║╚ń╣¹ÖCŲ„┘Yį┤▓╗ūŃŻ¼Į©ūhā×(y©Łu)Ž╚īóę╗ą®¾wŽĄ¬Ü┴óĄ─Ę■äš(w©┤)š¹¾w▀węŲŻ¼▀@śė┐╔ęį×ķ║╦ą─Ę■äš(w©┤)╣Ø(ji©”)╩Ī│÷┤¾┴┐Ą─ÖC╝▄┘Yį┤ĪŻ╚ń╣¹▀@śėų«║¾Ż¼ÖC╝▄┘Yį┤╚į╚╗▓╗ūŃŻ¼į┘ū÷«ÉĄžČÓ╗Ņ▓┐╩Ż╗

Ę■äš(w©┤)ĻP(gu©Īn)┬ō(li©ón)╩ŪʱÅ═(f©┤)ļsŻ║╚ń╣¹Ę■äš(w©┤)ĻP(gu©Īn)┬ō(li©ón)▒╚▌^║åå╬Ż¼ätå╬į¬╗»Īó╗∙ė┌┐ńÖCĘ┐Ž¹Žó═¼▓ĮĄ─ĮŌøQĘĮ░ĖČ╝┐╔ęį▓╔ė├ĪŻ▓╗╣▄──ĘNĘĮ╩ĮŻ¼ĻP(gu©Īn)┬ō(li©ón)Ą─Ę■äš(w©┤)ę▓Č╝ę¬ū÷«ÉĄžČÓ╗Ņ▓┐╩Ż¼ęį┤_▒ŻĖ„éĆÖCĘ┐ī”ĻP(gu©Īn)┬ō(li©ón)śI(y©©)äš(w©┤)Ą─šłŪ¾Č╝┬õį┌▒ŠÖCĘ┐ā╚(n©©i)Ż╗

╩ŪʱĘĮ▒Ńī”ė├æ¶Ęųģ^(q©▒)Ż║▒╚╚ń║▄ČÓė╬æ“ŅÉĪóÓ]ŽõŅÉĘ■äš(w©┤)ė╔ė┌ė├æ¶┐╔ęį║▄ĘĮ▒ŃĘųģ^(q©▒)Š═ĘŪ│Ż▀m║Žå╬į¬╗»Ż¼Č°SNSŅÉĄ─«a(ch©Żn)ŲĘę“×ķĻP(gu©Īn)ŽĄ╣½ė├Ą╚å¢Ņ}▓╗╠½▀m║Žå╬į¬╗»Ż╗

ųö╔„╠¶▀xĄ┌Č■ÖCĘ┐Ż║▒M┴┐╠¶▀xļxų„ÖCĘ┐▌^Į³Ż©ŠW(w©Żng)Įj(lu©░)čėĢrį┌10msęįā╚(n©©i)Ż®ŪęīŻŠĆ┘|(zh©¼)┴┐║├Ą─ÖCĘ┐ū÷Ą┌Č■ųąą─ĪŻ▀@śė┤¾ČÓöĄ(sh©┤)Ą─ąĪĘ■äš(w©┤)ę└┘ćå¢Ņ}Č╝┐╔ęį║å╗»Ą¶Ż¼┐╔ęį╝»ųąŠ½┴”╠Ä└Ē║╦ą─śI(y©©)äš(w©┤)Ą─«ÉĄžļp╗Ņå¢Ņ}ĪŻ═¼ĢrŻ¼īŻŠĆĄ─│╔▒Šš╝▒╚ę▓▒╚▌^ąĪĪŻęį▒▒Š®×ķ└²Ż¼ū÷«ÉĄžČÓ╗ŅĮ©ūh▀xō±╠ņĮ“Īóā╚(n©©i)├╔╣┼Īó╔Į╬„Ą╚ĄžĄ─ÖCĘ┐Ż╗

┐žųŲ▓┐╩ęÄ(gu©®)─ŻŻ║į┌öĄ(sh©┤)ō■(j©┤)īėūį╔Ēų¦│ų┐ńÖCĘ┐Ę■äš(w©┤)ų«Ū░Ż¼▓╗Į©ūh▓┐╩│¼▀^ā╔éĆĄ─ÖCĘ┐ĪŻę“×ķ«ÉĄžā╔éĆÖCĘ┐Ż¼«ÉĄž╚▌×─(z©Īi)Ą──┐Ą─ęčĮø(j©®ng)▀_│╔Ż¼ŪęĘ■äš(w©┤)Ų„ęÄ(gu©®)─ŻūŃē“┤¾Ė„ĘN┼õ╠ūĄ─įO(sh©©)╩®ę▓Ģ■▒╚▌^ĮĪ╚½Ż¼▀\ŠS│╔▒Šę▓ŽÓī”┐╔┐žĪŻ«ööUš╣ĄĮ╚²éĆ³cų«║¾Ż¼ą┬ÖCĘ┐╗∙ĄA(ch©│)įO(sh©©)╩®─ź║ŽĪó▀\ŠSøQ▓▀Ą─│╔▒ŠĄ╚Č╝Ģ■┤¾Ę∙į÷╝ėŻ╗

Ž¹Žó═¼▓ĮĘ■äš(w©┤)╗»Ż║Į©ūhöUš╣Ė„ūįĄ─Ž¹ŽóĘ■äš(w©┤)Ż¼Å─ųąķg╝■╗“š▀Ę■äš(w©┤)īė├µų▒Įėų¦│ų┐ńÖCĘ┐Ž¹Žó═¼▓ĮŻ¼ī󎹎ó¾w┤¾ąĪ┐žųŲį┌10kęįŽ┬Ż¼┐ńÖCĘ┐Ž¹Žó═¼▓ĮĄ─ąį─▄║═│╔▒ŠČ╝▒╚▌^┐╔┐žĪŻÖCĘ┐ķgĄ─öĄ(sh©┤)ō■(j©┤)ę╗ų┬ąįų╗═©▀^Ž¹Žó═¼▓ĮĘ■äš(w©┤)ĮŌøQŻ¼ÖCĘ┐ā╚(n©©i)▓┐ĮŌøQŠÅ┤µĄ╚┼cŽ¹ŽóĄ─ę╗ų┬ąįå¢Ņ}ĪŻ┐ńÖCĘ┐Ž¹Žó═¼▓ĮĄ─║╦ą─³cį┌ė┌Ž¹Žó▓╗─▄üGŻ¼╬ó▓®ė╔ė┌╩╣ė├Ą─╩ŪMCQŻ¼═©▀^▒ŠĄžīæ▀h│╠ūxĄ─ĘĮ╩ĮŻ¼┐╔ęį║▄ĘĮ▒ŃĄ─īŹ¼F(xi©żn)Ė▀ą¦ĘĆ(w©¦n)Č©Ą─┐ńÖCĘ┐Ž¹Žó═¼▓ĮŻ╗

«ÉĄžČÓ╗ŅĄ─ą┬ĘĮŽ“

ĢrķgĄĮ┴╦2015─ĻŻ¼ą┬╝╝ąg(sh©┤)īė│÷▓╗ĖFŻ¼ų«Ū░║▄ČÓ│╔▒Š║▄Ė▀Ą─╩┬Ūķ─┐Ū░Č╝ėą┴╦║▄║├Ą─ĮŌøQĘĮ░ĖĪŻĮėŽ┬üĒ╬ęéāīóį┌Į³╬Õ─Ļ«ÉĄžČÓ╗Ņ▓┐╩╠Į╦„Ą─╗∙ĄA(ch©│)╔ŽŻ¼└^└m(x©┤)īó╬ó▓®Ą─«ÉĄžČÓ╗Ņ▓┐╩¾wŽĄ╗»ĪŻ

╔²╝ē┐ńÖCĘ┐Ž¹Žó═¼▓ĮĮM╝■×ķ┐ńÖCĘ┐Ž¹Žó═¼▓ĮĘ■äš(w©┤)ĪŻ├µŽ“śI(y©©)äš(w©┤)Ė¶ļx┐ńÖCĘ┐Ž¹Žó═¼▓ĮĄ─Å═(f©┤)ļsąįŻ¼śI(y©©)äš(w©┤)ų╗ąĶę¬ī”Ž¹Žó▀Mąą╠Ä└Ē╝┤┐╔Ż¼Ž¹ŽóĄ─┐ńÖCĘ┐Ęų░l(f©Ī)Īóę╗ų┬ąįĄ╚ė╔┐ńÖCĘ┐═¼▓ĮĘ■äš(w©┤)▒ŻšŽĪŻŪę┐╔ęįū„×ķ╦∙ėąśI(y©©)äš(w©┤)┐ńÖCĘ┐Ž¹Žó═¼▓ĮĄ─īŻė├═©Ą└Ż¼Ė„éĆśI(y©©)äš(w©┤)Š∙┐╔ęįÅ═(f©┤)ė├Ż¼ŅÉ╦Ųė┌┐ņ▀f╣½╦ŠĄ─ĮŪ╔½ĪŻ

═Ų▀MWebīėĄ─«ÉĄž▓┐╩ĪŻė╔ė┌▀hŠÓļxīŻŠĆ│╔▒ŠŠ▐┤¾ŪęĘĆ(w©¦n)Č©ąį║▄ļy▒ŻšŽŻ¼╬ęéāęčĢ║ĢrĘ┼Śē▀h│╠«ÉĄž▓┐╩Ż¼Č°Ė─×ķśI(y©©)äš(w©┤)▀ē▌ŗĮ³ŠÓļxĖ¶ļx▓┐╩Ż¼īóWebīė▀Mąą▀h│╠«ÉĄž▓┐╩ĪŻ═¼ĢrŻ¼ėŗäØ▓╗į┘ę└┘ć░║┘FŪę▓╗ĘĆ(w©¦n)Č©Ą─īŻŠĆŻ¼Č°ĮĶų·ė┌═©▀^╦ŃĘ©īżšę▌^ā×(y©Łu)┬ĘÅĮĄ─ĘĮĘ©═©▀^╣½ŠW(w©Żng)▀MąąöĄ(sh©┤)ō■(j©┤)é„▌öĪŻ▀@śė╬ęéāŠ═┐╔ęįīóWebīė▓┐╩ĄĮļxė├æ¶Ė³Į³Ą─ÖCĘ┐Ż¼╠ß╔²ė├æ¶Ą─įLå¢ąį─▄ĪŻę└ō■(j©┤)╬ęéā?n©©i)ź─Ļū÷╬ó▓®Feed╚½µ£┬ĘĄ─Įø(j©®ng)“ׯ¼ųąķgµ£┬Ęš╝Ą¶┴╦90%ęį╔ŽĄ─ė├æ¶įLå¢ĢrķgŻ¼īóWebīė▓┐╩Ą─ļxė├æ¶Ė³Į³īó─▄┤¾┤¾╠ß╔²ė├æ¶įLå¢ąį─▄║═¾w“×ĪŻ

ĮĶų·╬óĘ■äš(w©┤)ĮŌøQųąąĪĘ■äš(w©┤)ę└┘ćå¢Ņ}ĪŻīóī”┘Yį┤Ą╚Ą─▓┘ū„░³čb×ķ╬óĘ■äš(w©┤)Ż¼▓óīóųąąĪśI(y©©)äš(w©┤)▀węŲĄĮ╬óĘ■äš(w©┤)╝▄śŗ(g©░u)ĪŻ▀@śėų╗ąĶę¬ī”ÄūéĆ╬óĘ■äš(w©┤)▀Mąą«ÉĄžČÓ╗Ņ▓┐╩Ė─įņŻ¼▒ŖČÓĄ─ųąąĪśI(y©©)äš(w©┤)Š═▓╗į┘ąĶę¬ĻP(gu©Īn)ą─«ÉĄž▓┐╩å¢Ņ}Ż¼Å─Č°┐╔ęįĄ═│╔▒Š═Ļ│╔▒ŖČÓųąąĪĘ■äš(w©┤)Ą─«ÉĄžČÓ╗Ņ▓┐╩Ė─įņĪŻ

└¹ė├Docker╠ß╔²Ū░Č╦┐ņ╦┘öU╚▌─▄┴”ĪŻĮĶų·DockerĄ─äėæB(t©żi)öU╚▌─▄┴”Ż¼«ö┴„┴┐▀^┤¾ĢrĘųńŖ╝ēÅ─Ųõ╦¹Ę■äš(w©┤)│žš¬Ž┬ę╗┼·ÖCŲ„Ż¼▓ó═Ļ│╔▒ŠĘ■äš(w©┤)│žĄ─öU╚▌ĪŻų«║¾ę▓┐╔ęįīóĖ„ĘN┘Yį┤ę▓╝{╚ļĄĮDockeräėæB(t©żi)▓┐╩Ą─ĘČć·Ż¼▀Mę╗▓ĮöU┤¾äėæB(t©żi)š{(di©żo)Č╚Ą─ÖCŲ„į┤ĘČć·ĪŻ

ęį╔Ž╩Ūī”╬ó▓®«ÉĄžČÓ╗Ņ▓┐╩Ą─ę╗ą®┐éĮY(ji©”)║═╦╝┐╝Ż¼ŽŻ═¹─▄ē“?q©▒)”┤¾╝ęėą╦∙åó░l(f©Ī)ĪŻ

║╦ą─ĻP(gu©Īn)ūóŻ║═ž▓ĮERPŽĄĮy(t©»ng)ŲĮ┼_╩ŪĖ▓╔w┴╦▒ŖČÓĄ─śI(y©©)äš(w©┤)ŅI(l©½ng)ė“ĪóąąśI(y©©)æ¬(y©®ng)ė├Ż¼╠N║Ł┴╦žSĖ╗Ą─ERP╣▄└Ē╦╝ŽļŻ¼╝»│╔┴╦ERP▄ø╝■śI(y©©)äš(w©┤)╣▄└Ē└Ē─ŅŻ¼╣”─▄╔µ╝░╣®æ¬(y©®ng)µ£Īó│╔▒ŠĪóųŲįņĪóCRMĪóHRĄ╚▒ŖČÓśI(y©©)äš(w©┤)ŅI(l©½ng)ė“Ą─╣▄└ĒŻ¼╚½├µ║Ł╔w┴╦Ų¾śI(y©©)ĻP(gu©Īn)ūóERP╣▄└ĒŽĄĮy(t©»ng)Ą─║╦ą─ŅI(l©½ng)ė“Ż¼╩Ū▒ŖČÓųąąĪŲ¾śI(y©©)ą┼Žó╗»Į©įO(sh©©)╩ū▀xĄ─ERP╣▄└Ē▄ø╝■ą┼┘ćŲĘ┼ŲĪŻ

▐D(zhu©Żn)▌dšłūó├„│÷╠ÄŻ║═ž▓ĮERP┘YėŹŠW(w©Żng)http://m.nttd-wave.com.cn/

▒Š╬─ś╦Ņ}Ż║Ī░«ÉĄžČÓ╗ŅĪ▒ČÓÖCĘ┐▓┐╩Įø(j©®ng)“ךä

▒Š╬─ŠW(w©Żng)ųĘŻ║http://m.nttd-wave.com.cn/html/consultation/10839418255.html